ChatGPTに教えてはいけない5つの機密情報とは

金融情報から健康データまで、AIチャットボットによる情報漏洩リスクの実態

今最も普及しているAIチャットボットはChatGPTだ。利用者が増えることで可能性は広がる一方で、個人情報を入力する危険性が深刻化している。専門家によると、AIチャットボットへの不適切な情報共有が新たなセキュリティリスクとして浮上している。

本記事では、ChatGPTに教えてはいけない5つの機密情報を解説する。ChatGPTに限らず、すべてのAIチャットボットに言えることなので、今後活用したいと思っている人は注意してもらいたい。

個人識別情報の危険性

氏名、住所、生年月日、社会保障番号などの個人を特定できる情報の入力は厳禁だ。OpenAIが新たなプライバシー保護機能を実装したものの、情報漏洩のリスクは依然として存在する。

アカウント情報の保護

ユーザー名やパスワードなどのログイン情報も要注意だ。セキュリティ専門家は、特にパスワードの使い回しがある場合、複数のサービスで不正アクセスの被害が連鎖的に発生する可能性を警告している。

金融情報の漏洩リスク

クレジットカード番号や銀行口座情報などの金融データの入力は、不正利用や詐欺被害に直結する可能性がある。OpenAIはこれらの情報を一切必要としておらず、入力自体が重大なリスクとなる。

企業機密情報の流出事例

サムスン電子では、社内の機密コードがChatGPTに入力され、深刻な情報流出事故が発生。これを受け、GoogleやAppleなど世界的テクノロジー企業の多くが、社内でのAIチャットボット使用に厳格な制限を設けている。

医療情報のプライバシー懸念

個人の健康データや病歴情報も要注意だ。医療プライバシーの専門家は、これらの情報がAIの学習データとして永続的に保存される可能性を指摘。具体的な症状は伏せ、一般的な質問にとどめることを推奨している。

対策と今後の展望

Humaneの「AI Pin」やアップルの「Vision Pro」など、プライバシーを重視したオンデバイスAIの開発が進んでいる。しかし、完全な安全性が確保されるまでは、個人情報の取り扱いに細心の注意が必要だ。

(Source: BGR)

もっと読む

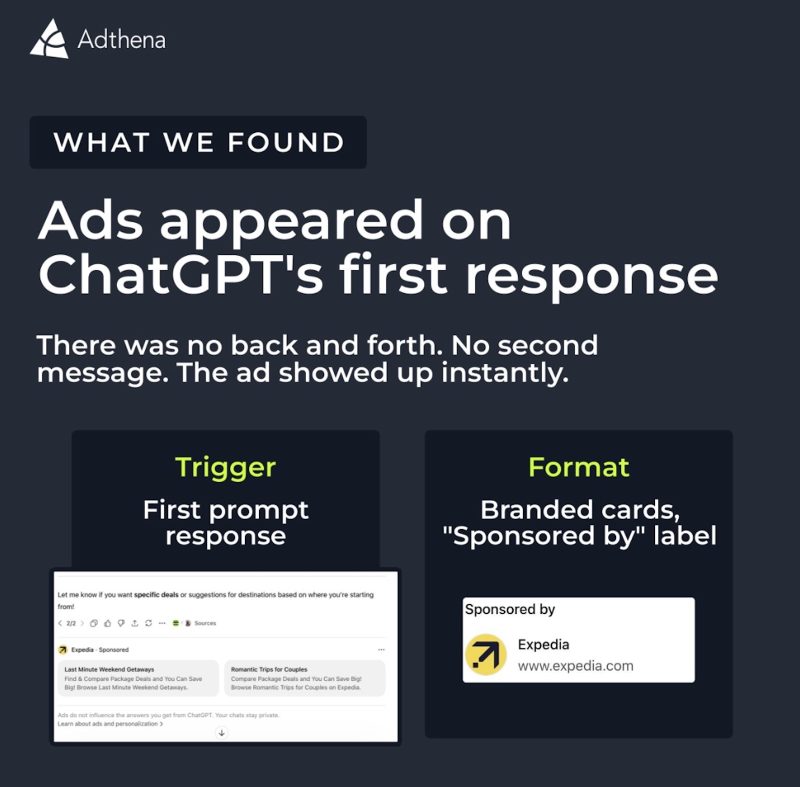

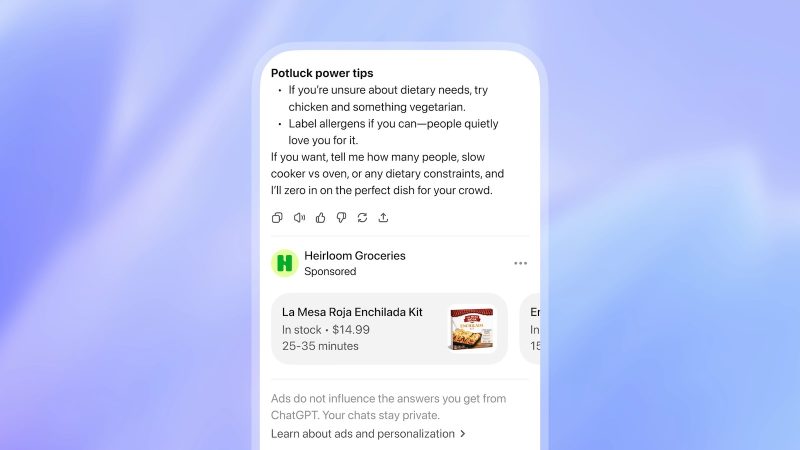

ChatGPTに広告が出てた。会話の最初からすぐ表示されるらしい

Claude Sonnet 4.6が登場。無料ユーザーも初めてSonnetクラスがデフォルトに

OpenClaw開発者がOpenAIに入社、次世代パーソナルエージェント開発へ

ChatGPT、米国で広告配信テスト開始──FreeとGoプランが対象、回答への影響はなし

Anthropic、Claude ProとMaxユーザーに50ドル分の無料クレジット配布中!とりあえず今すぐもらっておけ!

WSJの名物テック記者Joanna Sternさんが独立を発表!12年の在籍を経て自身のメディア企業を立ち上げへ

Anthropic、最上位AIモデル「Claude Opus 4.6」発表——GPT-5.2を上回る性能で100万トークン対応

OpenAI CEOがAnthropicを猛批判、「明らかに不誠実」「権威主義的」と痛烈反論

AnthropicがOpenAIとの違いを強調、スーパーボウルCMで「Claudeは広告なし」

OpenAI、ライバルのAnthropicから安全対策の専門家を引き抜き──アルトマンCEO「今夜はぐっすり眠れそう」

Fitbit創業者、今度は「家族全体の健康」を見守るAIサービスを立ち上げたらしい

OpenAI、エージェント型コーディング向けの新Macアプリ「Codex」をリリース—複数AI並行作業に対応

楽天「SPU」10周年記念、最大10万ポイントが当たるキャンペーン開始

Apple、AI規制で「プライバシー重視」貫く――OpenAI「大谷翔平の国」発言とは対照的に

テスラ「Model S」と「Model X」、生産終了へ──代わりに人型ロボット作るらしい

話題のAIエージェント「Clawdbot」、Anthropicに商標で怒られて「Moltbot」に改名

ChatGPT Health、10年分のApple Watchデータを「F」判定──実際の医師は「問題なし」

TikTokが米国での禁止回避。米国&投資家80%以上保有の合弁企業が誕生

マイナポータルとデジタル認証、2つのアプリが今夏統合へ

DeepLが流行りだした時も一般的なキーワード入れると、日本のどこかの会社の内部情報がガンガン吐き出されてて「あー、いろんな会社の担当者が″これコピペで英文の文書作れるんじゃね?″って試したんだろうなー」と思い出しました。