Google、2026年にAIスマートグラス発売。Gemini搭載で“スマホを取り出さない未来”が近づく

画面なし音声アシスト版とレンズ内ディスプレイ版の2モデルを展開。SamsungやWarby Parkerと協業し、Metaや将来のApple製品に挑む。

Googleは2026年に2種類のAIスマートグラスを発売することを明らかにした。1つ目はスクリーンレスでAIアシスタント機能に特化したモデル、2つ目はレンズ内ディスプレイを搭載した拡張現実(AR)対応モデルとなる。同社が本日発表した。

いずれのモデルもGoogle Geminiとの統合により、リアルタイムのAIアシスタンス機能を提供する。スマートフォンと連携し、処理は接続したデバイス側で行われる仕組みだ。

高精度なGemini搭載、ChatGPTを上回る評価も

最新のGeminiは精度が非常に高く、AIにどっぷり浸かっている人ほど「ChatGPTよりも良いのではないか」という論調が急激に増している印象を受ける。そのような評価を受けているAIがメガネ型デバイスに埋め込まれることは、圧倒的な強みになるはずだ。

何よりも、自社製デバイスのないOpenAIに対して、Googleは圧倒的な優位性を持つことになる。ハードウェアとソフトウェアの統合によるユーザー体験の最適化は、Appleが長年実証してきた成功モデルだ。

スクリーンレスAIグラス、カメラとマイクで周囲を認識

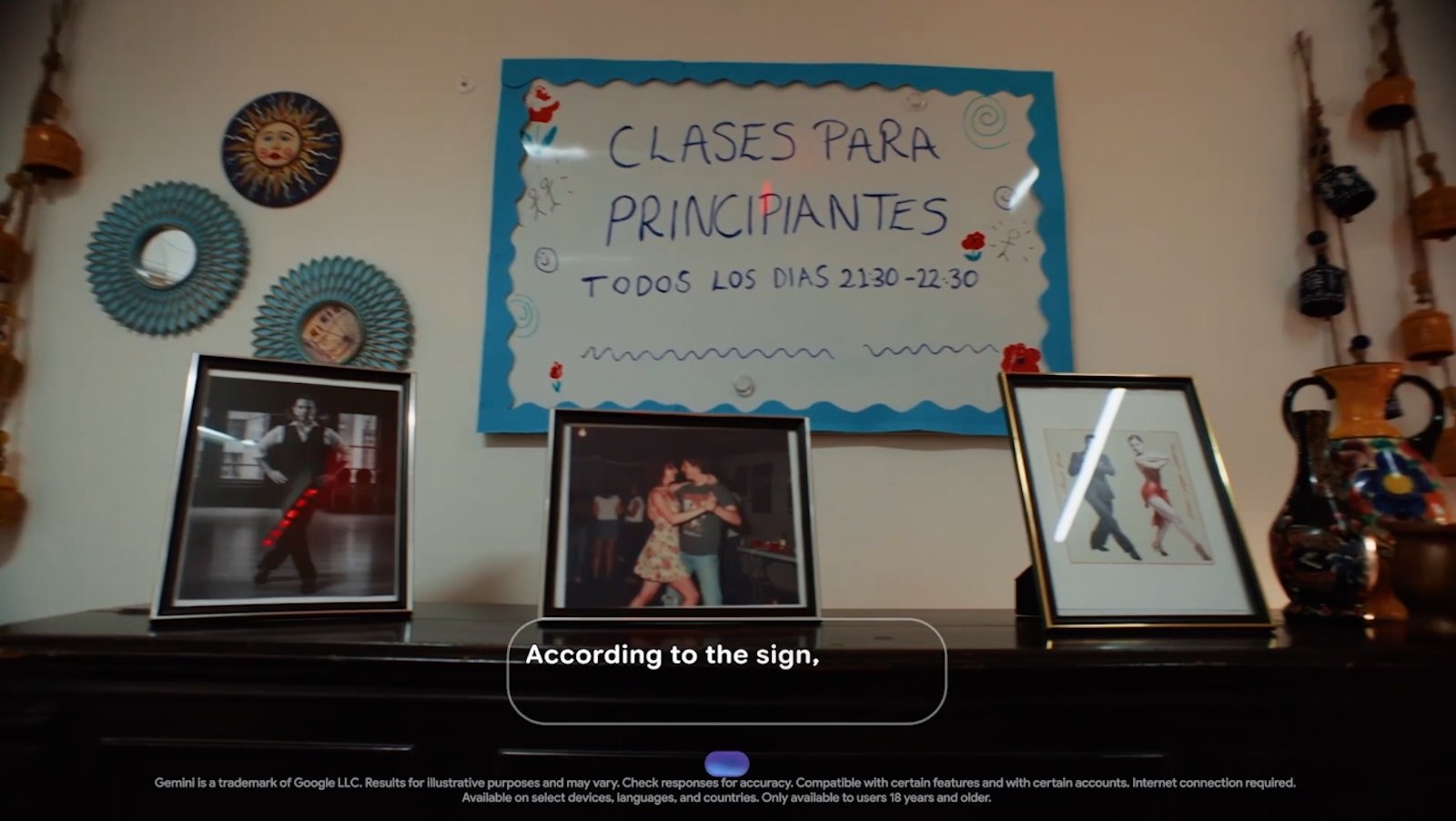

1つ目のスマートグラスは、内蔵スピーカー、マイク、カメラを搭載し、画面なしでGoogle Geminiとやり取りできる設計となっている。ユーザーはカメラで写真を撮影し、周囲の環境について質問することで、リアルタイムでサポートを受けられる。

このモデルは、視覚的な情報表示よりも音声によるインタラクションを重視したデザインとなっており、日常的な使用を想定している。

AR対応モデル、ナビや翻訳をレンズに表示

2つ目のスマートグラスは、1つ目と同じAI機能に加え、レンズ内ディスプレイを搭載する。ターンバイターンのナビゲーションやリアルタイム翻訳の字幕など、有用な情報を視界に直接表示できる仕様だ。

両モデルともAndroid XRを搭載し、Googleのウェアラブル向けプラットフォーム上で動作する。スマートフォンとの接続が前提となっており、グラス単体での処理は行わない。

音声入力の延長線上にある未来

僕自身、最近は両手が塞がっているときにiPhoneの音声入力を多用している。ちょっとしたメッセージを送るときや簡単に調べたいときに大活躍しており、最近はiPhoneを取り出すことすら面倒と感じるようになった。

その点、ディスプレイかつ音声が利用できるAIスマートグラスは物凄く良さそうだ。情報へアクセスするハードルがまた一段低くなることは間違いないだろう。

デザイン重視、Warby ParkerやGentle Monsterと協業

GoogleはSamsungとパートナーシップを組み、スマートグラスの開発を進めている。さらに、アイウェアブランドのWarby ParkerとGentle Monsterとも協力関係を構築した。

Googleによると、これらの提携により、スタイリッシュで軽量、かつ終日快適に着用できるデザインを実現するという。一般的な眼鏡と変わらない外観を目指している。

MetaとAppleとの競争激化へ

GoogleのAIスマートグラスは、すでに市場に投入されているMetaのRay-Banスマートグラスや、Appleが開発中とされる製品と競合することになる。MetaはすでにAI機能を搭載したRay-BanとOakleyのスマートグラスを販売しており、レンズ内ディスプレイを搭載したRay-Banモデルも展開している。

一方、Appleも2026年にも初のAIスマートグラスを発表する可能性があると噂されている。各社がAIとウェアラブル技術を組み合わせた次世代デバイスの開発を加速させており、2026年はスマートグラス市場の転換点となりそうだ。

もっと読む

Nano Banana 2、本日公開。競合の半額以下でリーダーボード1位に

Google I/O 2026、日程決定。今年は5月19〜20日開催

大手テック4社のAI投資、GDP比で「月面着陸レベル」に到達してしまう

Google、月額1,200円のAIプラン「AI Plus」を日本展開。従来プランの半額以下に

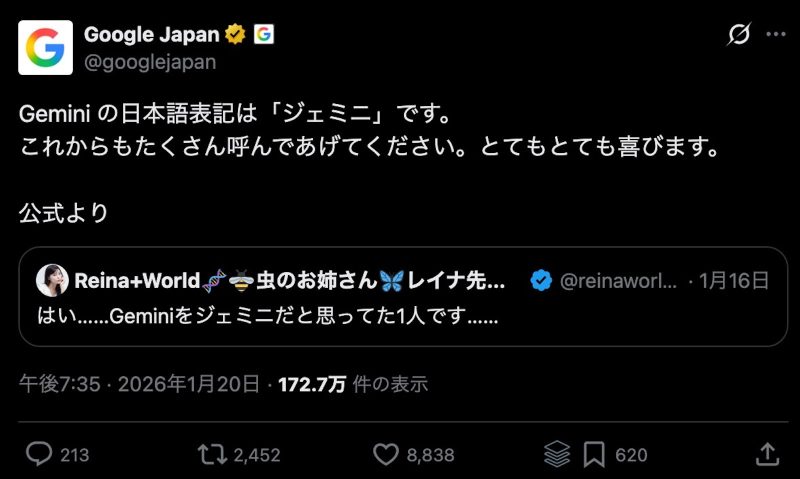

Geminiの読み方は「ジェミニ」で決着。Google Japanが日本語表記を”再度念押し”

Google「Geminiに広告? 出しません」——AI検索で稼げてるから焦らず慎重に

Google、iPhone版ChromeにGemini統合。AppleのSiri不在の隙狙う

Apple、GoogleとSiriの”運命”決める正式契約締結か。新AI検索も来年登場

GoogleがAppleに支払ってる年間約3兆円の検索料、継続OK判決が出ました

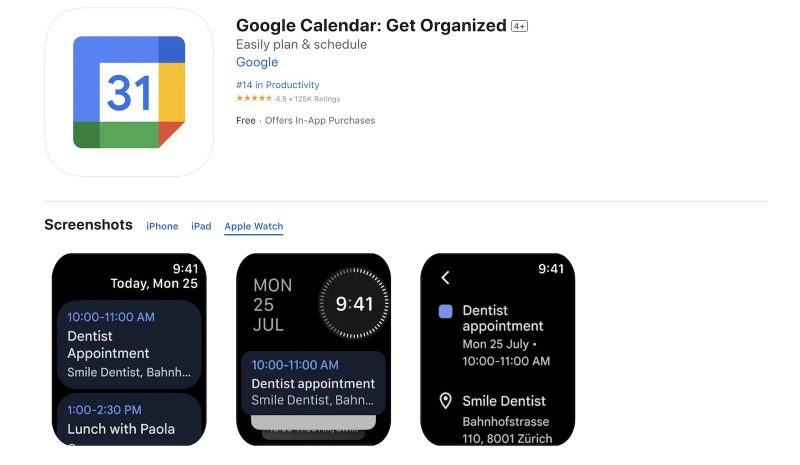

Googleカレンダー、待望のApple Watch用アプリをリリース!手首から予定管理が可能に

Apple IntelligenceのGemini統合、WWDC25発表は見送りか。独占禁止法訴訟が影響

Google「AI モード」、米国で一般提供開始。検索体験を一新、試着もできちゃう

米GoogleマップがiPhoneのスクリーンショットから場所を自動検出する新機能を追加

Googleが異例の反論!Apple幹部の「Safari検索減少」発言で株価7.5%急落

米司法省がGoogleに広告ビジネスの分割を要求、AdXとDFPの売却案が浮上

GoogleのAI Modeが米国で一般公開。検索体験が大幅進化、商品・店舗カードや履歴機能も追加

Google検索の独占是正案、米司法省とGoogleが法廷で激突──Pichai CEOが語った「検索サービス存続の危機」

”OpenAI Chrome”爆誕?ChatGPT責任者、「Chrome」買収に意欲表明

Googleが「巨額」の資金をSamsungに支払い、Geminiをプリインストール