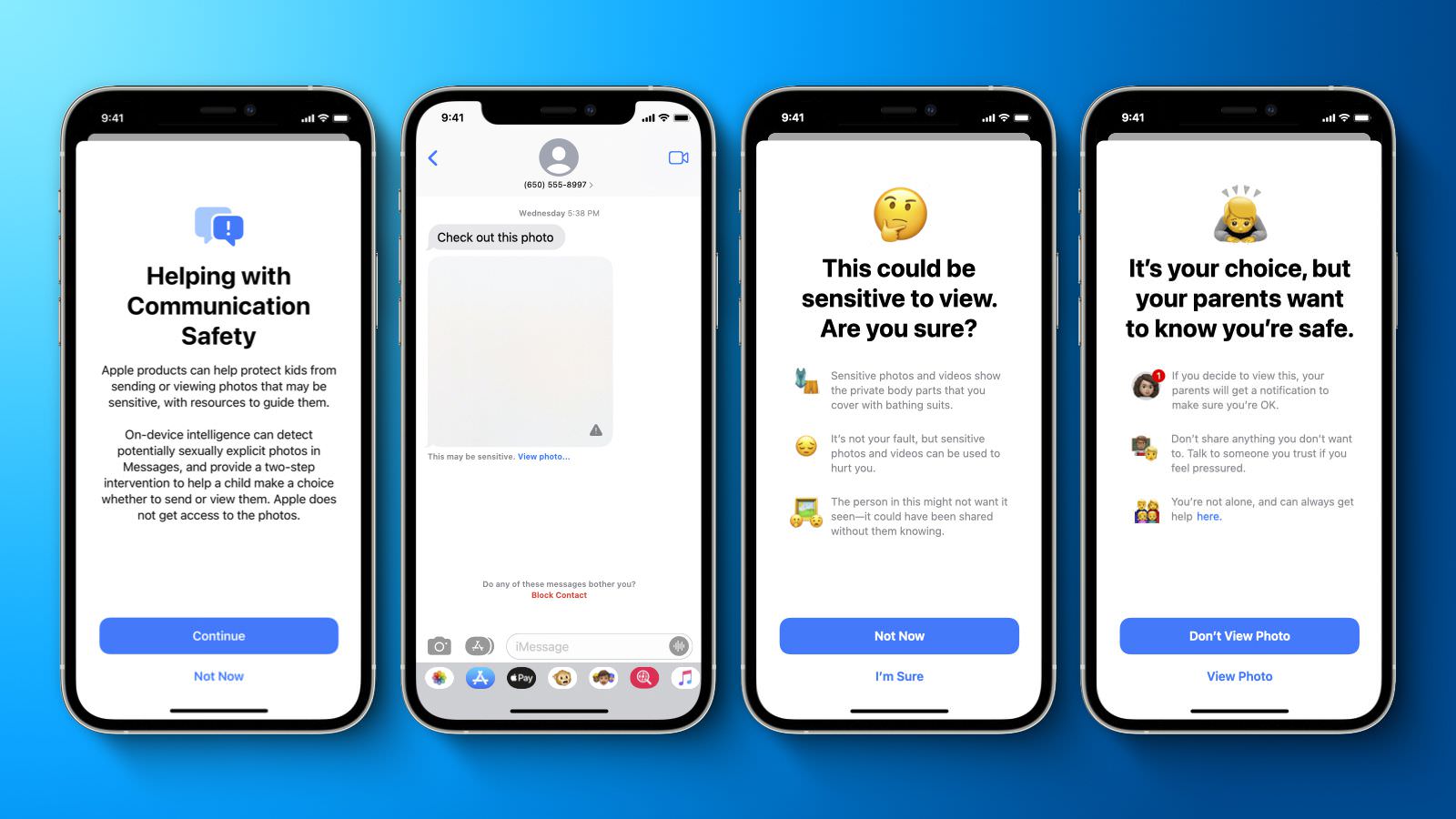

Appleのメッセージアプリで児童性的虐待コンテンツを検出する機能、日本で提供へ

ヌード写真が含まれるメッセージを警告、保護者に通達する機能

Appleは、純正メッセージアプリで児童性的虐待コンテンツ(Child Sexual Abuse Material = CSAM)を防止する機能を、近いうちに日本で提供開始する。日本経済新聞が明らかにした。現在は米国、イギリス、ドイツ、フランス、イタリア、スペインなど合計9カ国で提供されており、iCultureによると、日本以外にも、オランダ、ベルギー、スウェーデン、韓国、ブラジルで提供する。

新機能は、「メッセージ」アプリで送受信されるメッセージ内にヌード写真が含まれる場合、警告を表示した上で保護者に知らせる。利用にはiCloudのアカウント設定および保護者による事前同意が必要となっている。ヌード写真の検出はAIが行う仕組みで、Appleはメッセージの中身やヌード写真の検出状況は把握していない。

米国ではネットサービスを利用した児童への性的虐待が社会問題化している。Appleは2021年12月にiCloud写真の児童性的虐待コンテンツを検出する機能を発表したが、専門家などからの批判を受け、導入を断念した。

もっと読む

2024.08.21

2023.07.25

2023.03.28

2022.12.08

2021.07.20

2015.03.31

2015.01.04

2014.08.06

まだコメントはありません

最初のコメントを書いてみませんか?

関連キーワード

コメント(0件)

注意点

「Appleニュース・噂 ・最新情報」新着記事

ザッカーバーグ、裁判で明かした”秘密の接触”。2018年にクックへ「子供の安全を相談した」

2026.02.20

Apple、AIウェアラブル3製品を一気に開発加速か。スマートグラスは2026年末に生産開始の予想

2026.02.18

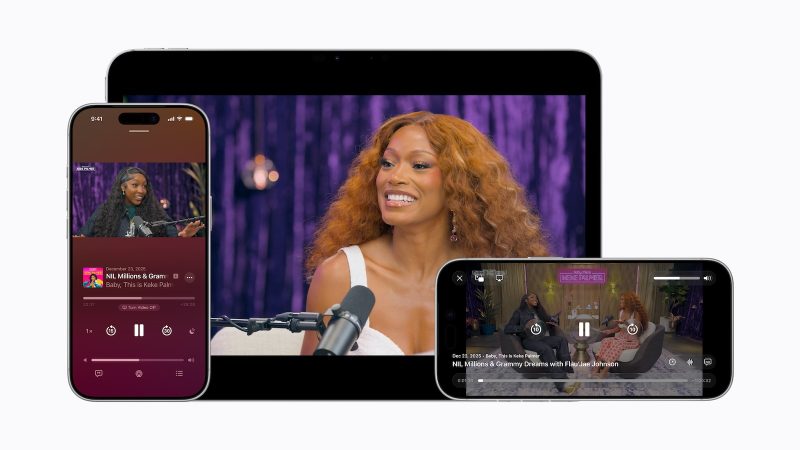

Apple Podcast、ポッドキャスターの収益化に革命。ビデオ広告を自由に挿入可能に

2026.02.17

Apple、2月23日に従業員向け新アプリ「Sales Coach」公開へ。AIチャットボットが販売支援

2026.02.14

Apple、新Siri「2026年内リリース」を改めて宣言。株価5%急落の翌日に異例の声明

2026.02.13

Apple、グラフデータベース企業「Kuzu」を買収。iWorkやFreeformへの統合に期待

2026.02.12

新Siri、iOS 26.4から延期か。iOS 26.5や9月のiOS 27まで先送りの可能性

2026.02.12

MacBook・iPad供給に暗雲。シャープ工場売却が破談、8月に生産停止へ

2026.02.12

Bad BunnyのSuper Bowlハーフタイムショーが記録的反響、Apple Musicで再生7倍・Shazam認識130%増

2026.02.10

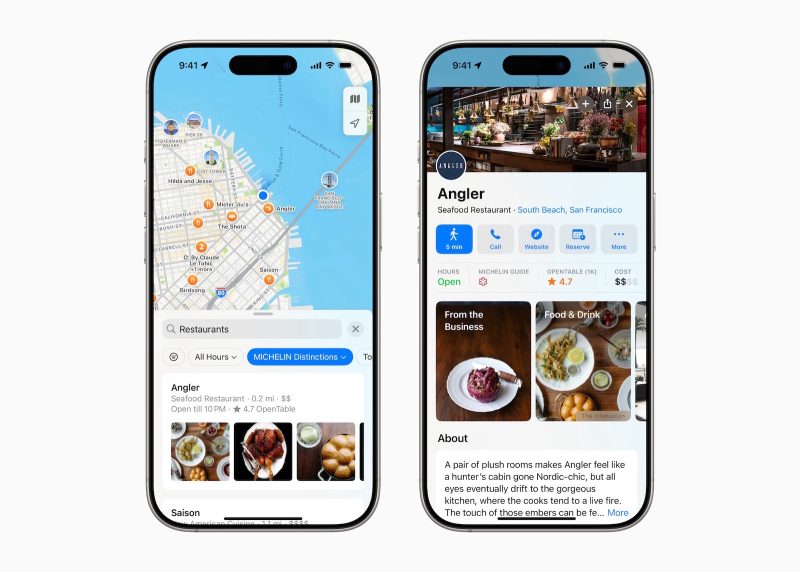

EU、Apple MapsとApple Adsを「ゲートキーパー」指定せず——Appleに珍しい朗報

2026.02.06

iOS 27のApple Health+、搭載直前で縮小との情報。一部機能は今年中に投入か

2026.02.06

Apple、50周年に向けて本気出す。Tim Cook「祝賀を約束」、AI活用の新製品カテゴリも予告

2026.02.06

Apple、10年続いたTSMC独占体制を終了か。TSMC→Intel”乗り換え”検討か

2026.02.03

Apple、AI規制で「プライバシー重視」貫く――OpenAI「大谷翔平の国」発言とは対照的に

2026.02.02

Apple「官僚がiPhoneのボタン配置を決めるな」――EU規制を痛烈批判、日本法は評価

2026.02.02

AppleのSiri幹部、Googleへ移籍してしまう。AI研究者4人も流出

2026.01.31

Tim Cook氏が断言。「これまで見たことのない革新」を今年提供へ

2026.01.31

Apple Creator Studio、Instagram公式アカウント開設してた

2026.01.31

Gemini版Siri、Private Cloud Computeで動作するってよ。クック船長が決算で言及

2026.01.30

Appleが急騰するメモリチップ価格に言及、今後の影響と対策を示唆

2026.01.30