Apple、自分の声を15分で生成できる機能を実装へ。iOS 17に向けて最新アクセシビリティ機能を発表

知的能力、視覚、聴覚、運動のアクセシビリティに関する新しいソフトウェア機能

Appleは5月17日、知的能力、視覚、聴覚、運動のアクセシビリティに関するソフトウェア機能を予告した。非発話者や発話能力を失うリスクのある個人向けのツールとして、今年後半にリリースする。具体的な時期は明らかにしていないが、今秋一般公開されるであろう「iOS 17」の新機能として追加されるだろう。

発表された新機能は以下のとおり。

認知障害を持つユーザーをサポートするAssistive Access

「Assistive Access」は、高コントラストのボタンと大きなテキストラベルを備えた独自のインターフェースを提供。ユーザーの認知負荷を軽減する狙いだ。

視覚的なコミュニケーションを好むユーザーに対しては、Messagesには絵文字のみのキーボードとビデオメッセージを録音するオプションが追加される。ホーム画面とアプリの視覚的なグリッドベースのレイアウト、またはテキストを好むユーザーのための行ベースのレイアウトが選択できる。

Live SpeechとPersonal Voice

「Live Speech」は、話すことができない人々や、時間とともに話す能力を失った人々を支えるために設計された。iPhone、iPad、Macで、ユーザーは自分が言いたいことを入力し、電話やFaceTimeの通話、さらには対面の会話中に音声として話すことができる。

「Personal Voice」は、自分に似た声を作成する機能。15分間の音声をiPhoneまたはiPadで録音することで、オンデバイスの機械学習機能を使って生成される。Personal Voiceで作成した音声は、Live Speechで使用できる。

Detection Mode(Point and Speak) in Magnifier

「Point and Speak」は、視覚障害を持つユーザーがカメラ越しに読み取れないものに指を向けることで読み上げてくれる。カメラ、LiDARスキャナー、そしてデバイス内の機械学習からの入力を組み合わせて実現しているという。

もっと読む

ザッカーバーグ、裁判で明かした”秘密の接触”。2018年にクックへ「子供の安全を相談した」

Apple、AIウェアラブル3製品を一気に開発加速か。スマートグラスは2026年末に生産開始の予想

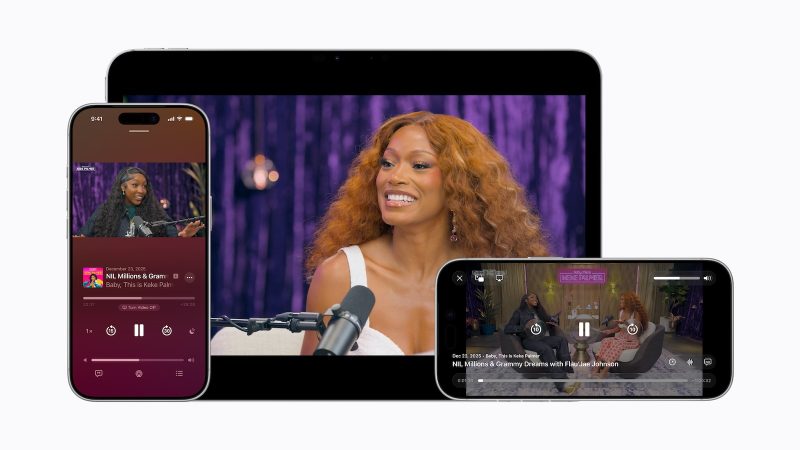

Apple Podcast、ポッドキャスターの収益化に革命。ビデオ広告を自由に挿入可能に

Apple、2月23日に従業員向け新アプリ「Sales Coach」公開へ。AIチャットボットが販売支援

Apple、新Siri「2026年内リリース」を改めて宣言。株価5%急落の翌日に異例の声明

Apple、グラフデータベース企業「Kuzu」を買収。iWorkやFreeformへの統合に期待

新Siri、iOS 26.4から延期か。iOS 26.5や9月のiOS 27まで先送りの可能性

MacBook・iPad供給に暗雲。シャープ工場売却が破談、8月に生産停止へ

Bad BunnyのSuper Bowlハーフタイムショーが記録的反響、Apple Musicで再生7倍・Shazam認識130%増

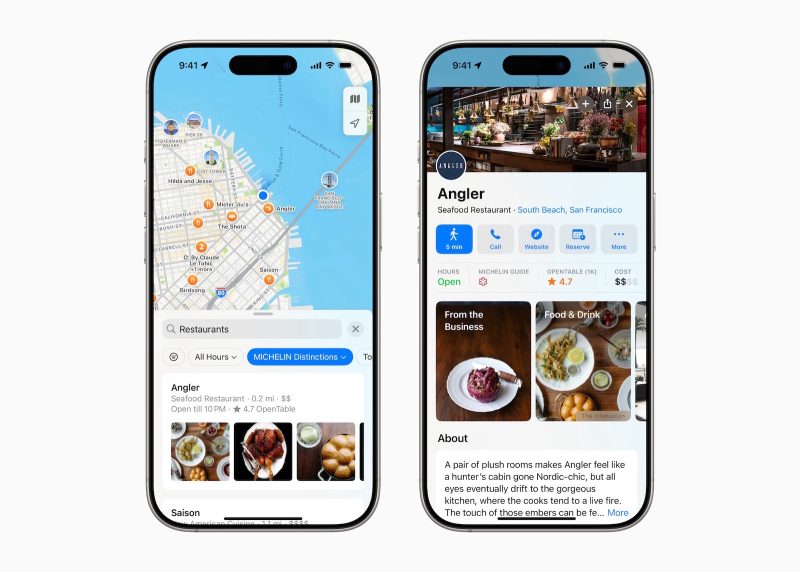

EU、Apple MapsとApple Adsを「ゲートキーパー」指定せず——Appleに珍しい朗報

iOS 27のApple Health+、搭載直前で縮小との情報。一部機能は今年中に投入か

Apple、50周年に向けて本気出す。Tim Cook「祝賀を約束」、AI活用の新製品カテゴリも予告

Apple、10年続いたTSMC独占体制を終了か。TSMC→Intel”乗り換え”検討か

Apple、AI規制で「プライバシー重視」貫く――OpenAI「大谷翔平の国」発言とは対照的に

Apple「官僚がiPhoneのボタン配置を決めるな」――EU規制を痛烈批判、日本法は評価

AppleのSiri幹部、Googleへ移籍してしまう。AI研究者4人も流出

Tim Cook氏が断言。「これまで見たことのない革新」を今年提供へ

Apple Creator Studio、Instagram公式アカウント開設してた

Gemini版Siri、Private Cloud Computeで動作するってよ。クック船長が決算で言及

すごいけど日本語は後やで!って事にはならんだろうか